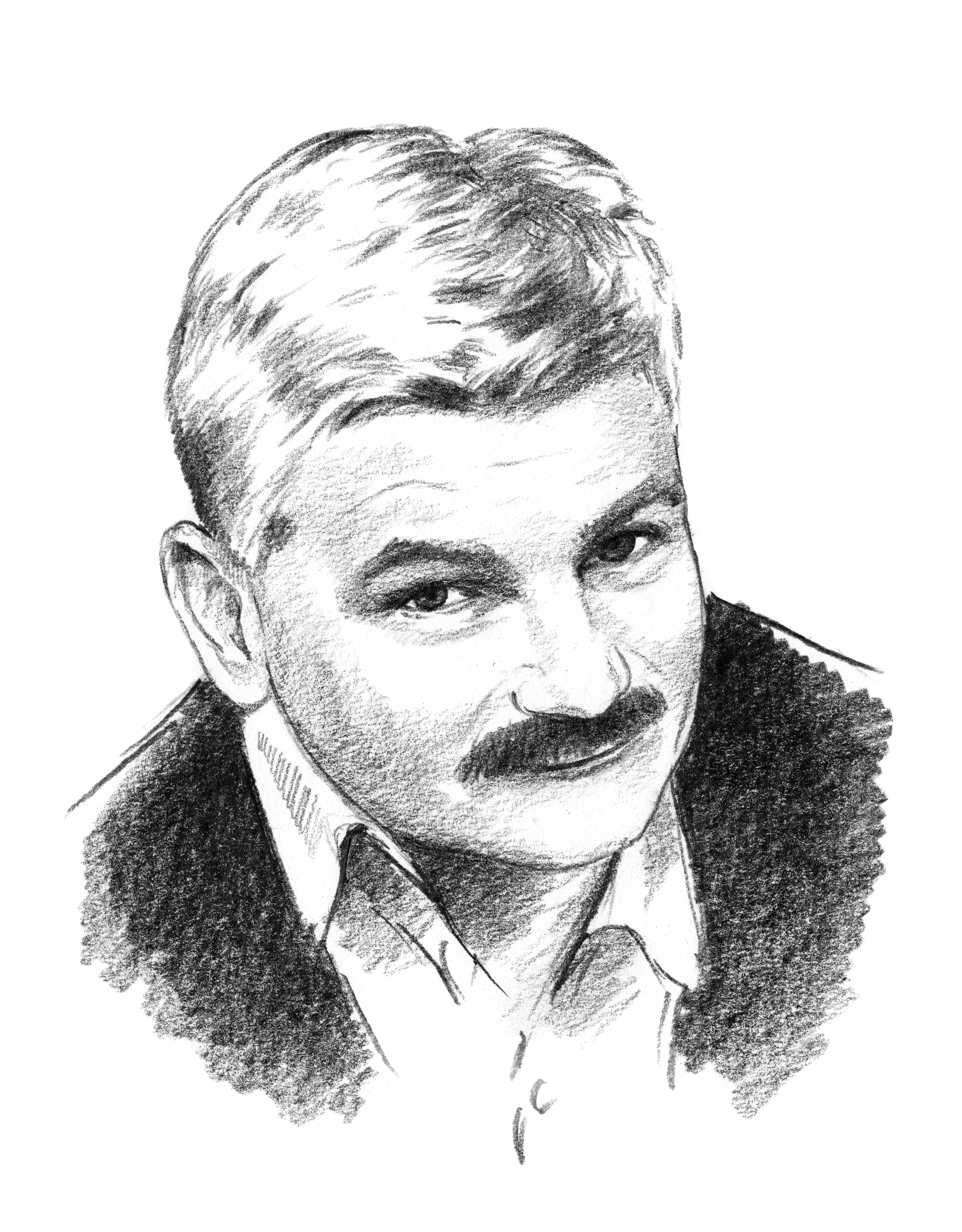

Edwin Bendyk jest pisarzem i publicystą obecnie związanym z działem naukowym tygodnika „Polityka”. Zajmuje się problematyką cywilizacyjną, kwestiami modernizacji, ekologii i rewolucji cyfrowej. Publikuje także w tygodniku „Computerworld”, „Res Publice Nowej”, Krytyce Politycznej”, „Przeglądzie Politycznym” i magazynie „Mobile Internet”. Jest także nauczycielem akademickim, wykłada w Collegium Civitas, gdzie kieruje Ośrodkiem Badań nad Przyszłością, a także w Centrum Nauk Społecznych PAN. Został też członkiem rady Fundacji Nowoczesna Polska oraz rady programowej Zielonego Instytutu.